Atención dividida y combinación de tareas

Introducción

Existen diversos puntos de vista sobre la explicación del rendimiento humano en condiciones de atención dividida.

Se han realizado experimentos sobre el Periodo Refractario Psicológico (PRP).

Welford (1952) utilizó tareas solapadas, primero un estímulo simple y después otro para emitir una respuesta rápida. Es la que se utiliza con mayor frecuencia.

Posner y Boies (1971) se basan en realizar dos tareas simultáneas, y Allport, Antonis y Reynolds (1972) requieren la realización continua de dos tareas mantenidas durante largos periodos temporales.

La teoría original del filtro sugería la existencia de un único canal de procesamiento, sin embargo Allport y Cols demostraron que se podía realizar de forma combinada dos tareas con la misma rapidez que si se hicieran por separado (experimento con teclistas de piano y sombreado de un texto) poniendo en evidencia el canal único de procesamiento atencional.

Broadbend (1982) señaló que en el experimento anterior existía cierta redundancia y predictibilidad entre palabras y notas por lo que para estar seguros de que no se comparte el tiempo entre ambas habría que diseñar tareas no redundantes.

¿Canal único o capacidad de procesamiento de propósito general?

Welford y Broadbent sugirieron la existencia de un cuello de botella central, otros teóricos opinaron que este cuello de botella no se debía a la estructura del sistema humano, si no a una cantidad limitada en la capacidad de procesamiento que se podía asignar a una tarea o a varias.

Ambas puntos de vista están relacionados entre si.

Si el recurso atencional que limita el sistema es de propósito general, todas las tareas que requieran atención utilizaran el mismo recurso o competirán en el mismo cuello de botella.

Siempre que dos tareas no compitan al mismo tiempo por el mismo recurso, no se interferirán, salvo que compitan en otro nivel común (por ej. a la extracción de datos).

Las teorías de la capacidad y el operador humano

Un cuello de botella selectivo en el procesamiento constituye una limitación estructural y muchos experimentos vistos en capítulos anteriores trataban de descubrir donde se encuentra dicho cuello de botella.

La cantidad de información que puede procesar un organismo en un momento dado podría considerarse que esta limitada por la capacidad o cantidad de recursos de procesamientos que dispone. Las investigaciones indican que el procesador humano dispone de límites en cuanto a número y complejidad de operaciones a realizar simultáneamente según las circunstancias (internas como personalidad, sueño, miedo o externas como ruido calor etc).

Revelle (1993) realizó una revisión de los factores “no cognitivos” que podían afectar a la capacidad del individuo para realizar tareas exigentes desde el punto de vista atencional, observó que la mayoría de los efectos estaban relacionados con la personalidad y con los niveles de activación o arousal.

Knowles (1963) propuso que el “operador humano” disponía de un pool o conjunto de recursos de procesamiento, y era limitado. Si una tarea necesita más recursos, en el pool quedarían menos recursos disponibles para otra tarea. Y a medida que la primera tarea fuera creciendo en dificultad, se extraerían cada vez más recursos.

Moray (1967) señalo que la visión del fenómeno atencional en términos de capacidad acabó con la necesidad de pensar en cuellos de botella. La interferencia entre tareas simplemente surgía de las demandas de capacidad de cada una de ellas, y podía aparecer en cualquier etapa del procesamiento.

El modelo de atención y esfuerzo de Kahneman

El modelo de Kahneman (1973) propone que la atención es un recurso limitado que se puede distribuir en función de la asignación de tareas, para una o para varias actividades. Sugiere que la capacidad atencional varía en función de la motivación y de la activación o arousal.

Propone que la dificultad de una tarea se puede determinar con su grado de interferencia con una tarea coincidente.

Este modelo presenta varios problemas:

-

Kahneman sugiere que a medida que aumenta la activación también lo hace el rendimiento, pero existe un punto óptimo, que una vez superado producirá una disminución del mismo. (Yerkes y Dodson)

-

No es fácil definir que es activación o arousal.

-

No se puede medir la dificultad de una tarea por su nivel de interferencia porque no sería una medida independiente.

Bourke, Duncan y Nimmo-Smith (1996) pusieron a prueba la teoría de la capacidad central con un experimento de dobles tareas, entonces las tareas que demandaran más capacidad interferirían con las otras y viceversa.

Generación de números aleatorios, aprendizaje de prototipos, atornillar y desatornillar tuercas y detectar tonos.

Se descubrió que la primera tarea (números) era la que ms interfería, independientemente si era una tarea primaria o secundaria y la última tarea (tonos) era la que menos de igual forma. Bourke y colaboradores llegaron a la conclusión de un límite responsable del descenso en situaciones de doble tarea pero no concluyeron si ese límite estaba en los recursos de procesamiento, o en la cantidad de información que se podía procesar.

Medición de la asignación de recursos

Limitaciones: procesamiento limitado por los datos y limitado por los recursos

Vickens utilizó el término recursos en vez de atención esfuerzo o capacidad, por considerar a estos últimos demasiado ambiguos.

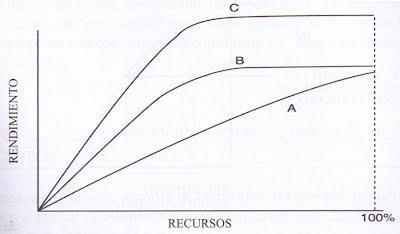

Norman y Bobrow manejaron la función recurso-rendimiento

Durante la ejecución de una tarea se pueden invertir recursos hasta un punto, a partir del cual no importan los recursos aportados, pues no mejorara el rendimiento por ello.

Existe limitación por los datos si el input es de mala calidad (conversación con ruidos o letras borrosas). Estas limitaciones no se pueden subsanar, pero si invertimos más recursos y el rendimiento cambia, esté será que está limitado por los recursos.

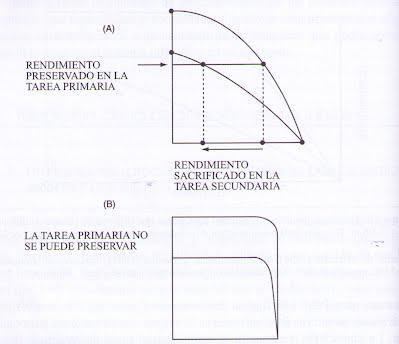

La curva POC (perfomance operating characteristic) es una representación gráfica de la asignación de recursos para cada tarea.

La curva A representa tareas que comparten un recurso (la mejora en el rendimiento de una tarea implica la disminución de la otra) y la curva B indica que no se comparten recursos o esta limitada por los datos.

Allport (1980) revisó la teoría de Norman y Bobrow y llegó a la misma conclusión que la teoría de Kahneman. No existe una manera independiente de medir las demandas de recursos. Si dos tareas interfieren, compiten por el mismo recurso, si no, utilizan recursos diferentes o están limitadas por los datos.

Hirst (1986) señaló que los psicólogos no tienen claro si existe un único recurso central para todas las tareas si hay múltiples recursos (pool visual para tareas visuales, pool verbal para verbales etc.) o si se combinan recursos específicos con un central.

El rendimiento en doble tarea: ¿De cuántos recursos disponemos?

Posner y Boies (1.971) realizaron un experimento de ejecución de dos tareas, una era comparar letras (igual-diferente) y otra detectar un tono que aparecía en diversas ocasiones durante la ejecución de la primera tarea.

Concluyeron que procesar la señal de advertencia requería escasa atención, pero si el tono aparecía al mismo tiempo que una de las letras, la respuesta era más lenta, pero no tanto si el tono aparecía durante en intervalo en la comparación de letras. El experimento evidenció la existencia de un límite general de procesamiento atencional.

McLeod (1977,1978) sin embargo, refutó el anterior experimento. Pidió a los participantes que en vez de pulsar una tecla cuanto apareciera el tono, dijeran “bip”.

Comprobó que no se producían interferencia entre ambas tareas (letras y tonos) si los sistemas de respuestas eran independientes, según esto, no había un limite general de procesamiento atencional al tratarse de dos esferas diferentes (visual y auditiva).

La explicación multirrecurso propone que las tareas solo interfieren si compiten por el mismo recurso.

Más efectos de compatibilidad estímulo-respuesta

Más tarde, MacLeod y Posner (1984) sugirieron que en condiciones de doble tarea existían relaciones entre estímulos y respuestas (input/output). El método básico incluía dos tareas. Comparación visual y después una combinación de esta con otra tarea auditiva. Había 4 grupos. 3 emitían una respuesta vocal a la tarea auditiva y movían una palanca a la izda o dcha si las letras eran iguales o diferentes. El cuarto grupo (intermodal) respondía manualmente a la tarea auditiva y vocalmente a la visual, respondiendo en voz alta “igual” o “diferente”.

Cada grupo realizo una tarea auditiva distinta.

Grupo 1: Sombrear el estímulo auditivo: Oían arriba/abajo y tenían que repetir la palabra.

Grupo 2: Oían arriba/abajo y tenían que responder “alto/bajo” (semánticamente).

Grupo 3: Oían alto y tenían que responder “arriba” o un tono de 400hz y responder “bajo”.

Grupo 4: Oían arriba/abajo y tenían que mover la palanca arriba o abajo.

El estimulo auditivo se presentaba en 6 momentos diferentes durante la tarea visual.

1: 700 ms antes de aparecer la letra1

2: 100 ms antes de aparecer la letra1

3: 100 ms después de aparecer la letra 1

4: 100 ms antes de aparecer la letra2

5: 100 ms después de aparecer la letra 2

6: 1.000 ms después de aparecer la letra 2

En las posiciones 1 y 6 no había solapamiento entre respuestas, en las 2 y 3 había que responder al estímulo a la vez que se codificaba la primera letra. En las posiciones 4 y 5 había que responder a ambas tareas a la vez.

Se concluyó:

-

Cuando las demandas de procesamiento de ambas tareas se solapaban en las posiciones 2, 3 ,4 y 5 se producía interferencia entre las tareas. El segundo grupo mostró más interferencia que el grupo primero y el grupo intermodal mostró mucha mas interferencia en las posiciones 3 y 4 es decir cuando había que dar una respuesta verbal a la tarea visual al mismo tiempo que se daba una respuesta manual a una tarea auditiva

-

Quedó claro el buen rendimiento cuando lo único que tiene que hacer el sujeto es sombrear o repetir, pero muy malo en la condición intermodal.

McLeod y Posner sugirieron la presencia de un bucle privilegiado independiente que permitía recuperar el programa fonológico articulatorio que participaba en la producción de palabras al escuchar una de ellas. Es decir se podía repetir una palabra al escuchar un sonido sin que interfiriera en otras tareas. Sin embargo si el estimulo auditivo llegaba cuando el sujeto estaba esperando para emitir una respuesta ante la tarea visual, esta causaba interferencia. Según ellos existía un vínculo automático entre un input auditivo y una respuesta vocal.

Si existieran otros bucles privilegiados input/output indicaría que existen varios canales de procesamiento de la información. Solo se observarían interferencias cuando existiera una competencia específica entre canales, que aparecería siempre y haría que algunas tareas fueran imposibles de combinar sin costes.

Shaffer(1975) descubrió que los mecanógrafos podían copiar en su maquina un texto escrito y realizar una tarea de sombreado, pero no podían mecanografiar al dictado y leer en voz alta a la vez.

Esto quiere decir que cuando las persona escuchan un mensaje, el bucle privilegiado de las palabras oídas tendía a activar programas motores para su pronunciación y se produciría interferencia, sin embargo es más sencillo mecanografiar y sombrear porque existe una ruta directa del input (sombreado) al output (hablado).

El periodo refractario psicológico

El PRP ya se ha incluido como evidencia a favor de la existencia de un cuello de botella en el procesamiento. Cuando se presentan dos estímulos que requieren dos respuestas, si se hace de tal forma que el segundo aparezca antes de emitir la respuesta del primero, la segunda respuesta tiende a retrasarse. Cuando más rápido se presenten mas se retrasa la respuesta al segundo. Ese retraso se conoce como periodo refractario psicológico.

Welford (1952) sugirió que el PRP demostraba la existencia de un mecanismo de capacidad limitada, que solo se podía procesar una decisión de respuesta a la vez y que esto formaba parte de la teoría de atención monocanal.

El efecto de la compatibilidad estímulo-respuesta en el PRP

Ya vimos que la compatibilidad estímulo/respuesta es una factor importante en el PRP Posner y Boies primero y McLeod después realizaron experimentos acerca de ello.

Greenwald y Schuldman (1973) también realizaron sus experimentos. Cuando el estímulo y la respuesta eran compatibles, no se producía refractariedad (decir uno al escuchar uno), sin embargo cuando el ER no era compatible (decir A al oír uno) si se producía retraso.

Pashler (1984) amplió estudios sobre PRP y se preguntó: ¿el PRP se debe a un cuello de botella central o a la diferencia entre estímulos y respuestas?

Si la explicación del cuello de botella fuera correcta, habría refractariedad incluso con tareas diferente y si se debiera a la diferencia ER no debía de producirse refractariedad con tareas diferentes.

Los resultados de sus experimentos concluyeron que si existía un cuello de botella en el procesamiento a pesar de que las tareas difirieran entre si.

Fagot y Pashler (1992) sostuvieron que había dos explicaciones para el cuello de botella en el procesamiento.

-

Una vez identificado el objeto, se utiliza la atención focal para enviar información sobre él a la fase de decisión de respuesta, donde el mecanismo pertinente seleccionaba de entre las respuestas posibles para ese objeto.

-

El cuello de botella solo podría seleccionar una respuesta siendo irrelevante el número de objetos.

Un modelo de sistema de producción para explicar el cuello de botella en el PRP

Fagot y Pashler sugirieron un modelo sencillo basado en un sistema de producción (condición acción, Si semáforo rojo = parar, si olor a gas = cerrar llave).

Propusieron que un modelo que intentara explicar el cuello de botella como sistema de producción debería de tener las siguientes propiedades:

-

Antes de realizar la tarea se activan unas reglas de selección de respuestas, cuantas más se activen, menor será la activación individual de cada una de ellas.

-

Para cada regla existe una condición y una acción, cuanto mayor sea la activaron de la regla, mas rápido se aplicará.

-

Solo se puede aplicar una regla cada vez

-

Una regla puede especificar múltiples acciones motoras.

Es necesario generar o recuperar un código en la memoria para encontrar la acción adecuada para una condición. Sugirieron que el cuello de botella se encontraba en el punto de generación de ese código y que solo se podía recuperar una respuesta a la vez. Los mecanismos posteriores (consulta de especificaciones de respuesta y transformación en acciones) no están limitados

¿Existe el cuello de botella?

Si el PRP se debe a una competencia en la recuperación de la memoria y en la selección de respuesta, no debería importar que tarea se realice primero. Existen evidencias que sugieren que el orden de las respuestas en el ensayo anterior influye en la respuesta que se da al siguiente.

De Jong (1995) examinó cómo se organizaba y controlaba el rendimiento en dos tareas que se solapaban. En sus experimentos, a los sujetos se les presentaban estímulos siguiendo un orden impredecible, y se encontró que lo que afectaba al rendimiento era el orden esperado. Sugirió que estaba controlado por una estructura de control multinivel que prepara el sistema para el procesamiento inmediato de la primera tarea y para cambiar de manera oportuna y rápida a la segunda tarea (pág.21). Consideró que esta compatibilidad podía exigir menos demandas de capacidad de procesamiento del canal central.

Schumacher (2001) demostró que los tiempos entre tareas se comparten de forma casi perfecta.

Hazeltine, Teague e Ivry (2002) encontraron resultados similares.

Existe un debate sobre si el efecto del PRP podría suprimirse si las tareas fueran compatibles desde el punto de vista ideomotor.

Lien, Proctor y Allen (2002) propusieron que la compatibilidad ideomotora no suprimía el PRP, y era necesario aclarar el propio concepto para conocer su importancia para la combinación de tareas.

Greenwald (2004) decía que se podía demostrar empíricamente una distribución de tiempos perfecta entre tareas si se hacía hincapié en la velocidad de respuesta y que la compatibilidad ideomotora no era condición suficiente para obtener dicha distribución.

Explicaciones alternativas del PRP

Existe una distinción entre la atención como un único canal y la atención como recurso, por lo tanto existen diferencias similares en las explicaciones del PRP.

Tombu y Jolicoeur (2003) compararon y contrastaron distintos enfoques y expusieron su propio modelo. Distinguieron entre: Teoría del cuello de botella estructural (Welford y Pashler), teoría del cuello de botella estratégico (Meyer y Keieras) y teoría de la capacidad compartida (Kahneman, Navon, Gopher, y luego Navon y Miller).

Teorías del cuello de botella estructural

Cuando dos tareas se solapan en el tiempo tanto la primera como la segunda parecen tener que recurrir al mismo mecanismo que recupera el código necesario para emitir la respuesta. Si está ocupado procesando la información de la primera tarea, la otra tendrá que esperar. Esta espera es lo que causa el PRP.

El cuello de botella monocanal explica una propiedad del PRP, la de la interacción entre el PRP y el retraso temporal entre la presentación del estímulo de la 1a y la 2a tarea.

Cuando las asincronías en la aparición del estímulo (SOAs) son prolongadas entre las tareas 1 y 2, la 1 ha sido procesada en el estadio del cuello de botella cuando se presenta el estímulo de la 2.

Conclusión: No existe competencia entre tareas, y la tarea 2 no muestra retraso.

Con SOAs breves, la tarea 1 sigue ocupando el cuello de la botella justo cuando lo necesita la tarea 2, por eso la tarea 2 se retrasa hasta que la tarea 1 haya terminado de utilizar los procesos de dicho estadio.

Mientras se vayan acortando los SOAs, tarea 2 esperará cada vez más para utilizar el cuello de botella. Dado que la tarea 1 siempre accede primero, la SOA no debería afectar a esta tarea.

Teorías del cuello de botella estratégico: Modelos de control ejecutivo

Meyer y Kieras (1997a, 1997b y 1999) propusieron el Modelo de Control Interactivo del Proceso Ejecutivo (EPIC) para el rendimiento con doble tarea y el PRP.

A priori, una vez aprendida una habilidad o destreza, debería ser posible combinarla sin coste con otra tarea que exija otra destreza, porque ninguna de ellas requerirá procesamiento central. Si apareciera interferencia sería:

-

La destreza no este suficientemente aprendida

-

La existencia de un control ejecutivo estratégico.

En este modelo la interferencia sigue estando en el cuello de botella, pero puede existir el EPIC que pospondría o daría prioridad a determinada tarea.

La distribución perfecta de tiempos solo es posible en condiciones adecuadas que según estos autores no se da habitualmente.

Logan y Gordon (2001) propusieron el modelo de control ejecutivo de la teoría de atención visual (ECTVA). Este modelo permite asignar prioridades a las tareas, incorpora mecanismos que participan en el control de asignación de recursos, establecimiento de metas de rendimiento e inhibición de respuestas no deseadas.

Teorías de la capacidad compartida

Según esta clase de modelos, las tareas pueden realizarse en paralelo pero en lugar de un cuello de botella estructural, existe una cantidad limitada de recursos de procesamiento. Al ser los recursos limitados, las tareas 1 y 2 tienen que compartirlos.

Tombu y Jolicoeur (2003) sugirieron que la mayor parte de la capacidad se habría asignado a la tarea 1 y por tanto los resultados confirmaban la existencia de un único canal de procesamiento.

Desarrollaron un modelo de capacidad central compartida, según el cual, unos estadios de procesamiento poseen capacidad limitada llamándolos “estadios centrales”, en ellos se podían procesar varios estímulos a la vez cuando las tareas se solapaban en el tiempo, pero tenían que compartir la capacidad, con lo que ralentizaba el procedimiento. Sólo los estadios centrales podían compartir el procesamiento entre tareas. Los otros estadios eran el “precentral” y el “postcentral”.

Cuando compartían la capacidad central, cada una de ellas tomaba una “proporción de reparto” de la capacidad total, q oscilaba entre 0 y 1.

Examinaron dos supuestos:

-

Con las SOAs prolongadas, no existía solapamiento central entre las tareas 1 y 2.

-

Con SOAs breves, donde la tarea 1 empezaba con pleno acceso al procedimiento central y utilizaba toda la capacidad disponible.

Cuando la tarea 2 comenzaba a utilizar la capacidad de procesamiento central, las tareas 1 y 2 debían compartir dicha capacidad hasta que la tarea 1 hubiera terminado el procesamiento central.

SOA (Stimulus Onset Asynchrony): tiempo transcurrido desde que aparece la señal a que aparece el objetivo

Navon y Miller (2002) argumentaron que dado que el paradigma de doble tarea está fuertemente sesgado a favor de una reacción rápida ante el estímulo que aparece primero, no resulta óptimo para someter a prueba el modelo del cuello de botella central.

Pashler y Johnston (1989) propusieron que estos modelos no podían explicar algunos hallazgos, como que el contraste entre el estímulo y el fondo sobre el que se presenta afectan al tiempo de respuesta en la tarea 2. Para ellos la dificultad de discriminar el estímulo de la tarea 2 no necesita procesamiento en el cuello de botella y debería de ser capaz de proseguir mientras se termina la tarea 1.

Así, con SOAs breves se puede procesar la tarea 2 antes del cuello de botella al mismo tiempo que la tarea 1 y con SOAs prolongados entre tarea 1 y 2 la discriminación del target de la tarea 2 no puede comenzar hasta que se presenta y por lo tanto no se puede avanzar en el procesamiento previo al cuello de botella mientras la tarea 1 se este procesando en él.

Pashler también argumentó en contra de estos modelos de reparto de la capacidad.

Cuando los participantes eran libres de responder en el orden que quisieran a la tarea 1 (un tono) o a la tarea 2 (una letra) con una SOA cero, ambas tareas recibirían una cantidad igual de capacidad disponible y terminarían al mismo tiempo.

Cuando el orden era aleatorio, una tarea terminaría siempre antes que la otra, la distribución de los TR sería dispersa y con el centro en 0. Así que, y según Pashler si el rendimiento se explicara mejor a través del cuello de botella, aparecerían patrones de respuesta diferentes, dependiendo de la estrategia de respuesta del participante.

Tombu y Jolicoeur (2003) sugirieron que este resultado no constituía evidencia en contra de la distribución o reparto de capacidad porque es de sobra conocido que la respuesta en el ensayo anterior ejercer influencia sobre el siguiente.

En general existe una gran dificultad en establecer evidencias empíricas entre el modelo de cuello de botella y el del reparto de la capacidad central en el PRP.

El control de las tareas en experimentos de PRP

De Jong (1995) examinó como se producían el cambio a la segunda tarea en el PRP y sugirió dos componentes en la operación de control, ambos podrían beneficiarse de la preparación previa e influir en el efecto PRP.

-

Recuperación de reglas de la memoria

-

Operación para implementarlas

Luria y Meiran señalaron que una de las explicaciones mas extendidas sobre el PRP (Phasler) no explicaba el control del orden de las tareas en PRP. Si se pudieran demostrar en experimentos, efectos debidos al orden se podrían establecer una diferencia entre las teorías en conflicto.

Cuando los participantes tienen que pasar de una tarea a otra, se produce un tiempo de respuesta mayor que en tareas repetitivas. Eso se denomina “coste por cambio”.

Ambos autores realizaron experimentos:

En la condición de orden fijo, el orden de las tareas era constante (1o letra, luego color o viceversa pero siempre en el mismo orden). En este caso el único coste se produciría dentro del ensayo para cambiar.

En las demás condiciones se mezclaron ensayos de cambio/no cambio (1o color, luego letra o viceversa, pero cambiando aleatoriamente).

Los resultados indicaban que la información sobre el orden se podía activar antes de la ejecución de la tarea porque el coste por cambio se reducida cuando la preparación era mas prolongaba. Sin embargo la necesidad de controlar el orden interactuaba con el efecto PRP, incrementando ese cuando se necesitaba más control.

El parpadeo atencional

La muestra de una secuencia rápida de targets sucesivos se conoce como PRSV (presentación rápida de series visuales) y se diferencia del PRP en que mientras en el primero solo se presentan dos targets a los que hay que responder, en la PRSV se requiere estar atentos a una secuencia de estímulos (normalmente letras) y responder cuando se detecte uno (normalmente por el color) a un ritmo de unos 100ms por item.

Broadbent y Broadbent (1987) comunicó el primer patrón de resultados, concluyendo que el procesamiento atencional de los ítems que seguían al target se dificultaba entre los 200 y 500ms. Este fenómeno se denomina PA, parpadeo atencional. Es como si la atención dejara de estar disponible momentáneamente (similar a la visión cuando parpadeamos).

Es decir, si se identifica un target y después llega otro, es probable que el segundo sea ignorado.

Por lo general el estímulo presentado inmediatamente después de un target se pasa por alto y el peor rendimiento se produce cuando el target 2 se presenta en la posición +2( 0 target, -1, -2 etc. posiciones anteriores, +1, +2 etc. posteriores). La detección del segundo target va mejorando hasta la posición +6, cuando desaparece el PA.

La CR (ceguera para la repetición) es un efecto relacionado con el PA en el cual los observadores no consiguen detectar la repetición de un ítem en una serie de PRSV.

Chun y Potter (2001) sugieren que el PA se produce por limitaciones de capacidad a la hora de consolidar la información visual en la memoria operativa y en la consciencia.

Proponen que el procesamiento en la PRSV consta de dos etapas:

-

Codificación inmediata de los ítems como targets no existen límites en la capacidad de procesamiento, sus representaciones son frágiles o decaen o se sobrescriben por los estímulos siguientes de la PRSV.

-

apacidad de procesamiento limitada en capacidad ya que sigue ocupada por el ítem anterior.

Es decir, los ítems que aparecen más tarde en la serie tienen que esperar a que el cuello de botella de la etapa 2 quede libre. Ese periodo de espera se el que produce el parpadeo atencional.

Una explicación alternativa sugiere que el PA se debe a una interferencia porque los ítems que llegan muy juntos compiten por un conjunto limitado de recursos de procesamiento.

Raymond, Shapiro y Arnell (1992) observaron que no se producía PA cuando el T1 iba seguido de un espacio en blanco o no se pedía su identificación. Sin embargo cuando se presentaba un estímulo después del target, pero antes de identificarlo si se producía PA.

Estos autores observaron que la búsqueda del target sigue una etapa más o menos secuencial.

-

Todos los ítems del campo visual se procesan en paralelo (simultáneamente) en búsqueda de características visuales, espaciales o categoriales.

-

Las representaciones se comparan con una plantilla target interna de características definitorias de dicho target

-

Cuando se selecciona un ítem como coincidente con la plantilla anterior se comienzan a utilizar recursos de procesamiento durante aprox. 500ms. Esta última etapa se denomina tiempo de permanencia atencional. Durante este tiempo las características del ítem se procesan en una representación integrada que permite al ítem ubicarse en la MCPV (memoria corto plazo visual). Para que un ítem pueda entrar en la MCPV se tiene que abrir una puerta, pero esta no se cierra inmediatamente y pueden entrar ítems muy cercanos en el tiempo.

Recientemente Awh, Serences, Laurey, Dhaliwal, Van de Jaght y Dasonville (2004) han puesto en evidencia los modelos de canal único y los de interferencia como explicación del PA.

Encontraron PA cuando el T1 era un dígito y el T2 una letra, pero cuando el T1 era un dígito y el T2 una cara no se producía PA.

Según ellos existía un canal que procesaba características comunes de letras y dígitos y otro para la discriminación de caras, y que ambos canales no se interferían .

La relación entre PRP y PA

Ambos fenómenos coinciden en que se ve afectada la capacidad para atender al segundo target cuando este se presenta aprox 500ms después del primero, que a medida que se van separando ambos targets va desapareciendo el PRP y PA y que el target primero no se ve influido por la necesidad de realizar una tarea a continuación.

Existen también diferencias: Mientras que en un experimento de PRP solo se presentan dos estímulos y la variable dependiente es la rapidez de respuestas, en experimentos de PA se presentan numerosos estímulos y la variable dependiente es la precisión en la detección del target.

Para poner a prueba la relación entre ambos fenómenos se utilizan paradigmas híbridos PRP/PA en que una respuesta exige rapidez ante un estímulo auditivo y otra precisión ante uno visual (paradigma SA-UV speeded auditory/unspeeded visual [Arnell y Duncan (2002)]) para demostrar si los recursos eran compartidos o se producían limitaciones en el rendimiento con doble tarea.

Parece que existen pruebas de la existencia de recursos compartidos y de recursos específicos en los paradigmas de doble tarea, tanto en el caso de PRP como en el PA y ninguna de ellas explica la totalidad de los fenómenos de PA y PRP, aunque son válidas en determinadas regiones del espacio de tareas.