Los cognitivismos: I. Orígenes

Podemos hablar indistintamente de psicología cognitiva o cognitivismo y así lo haremos en este capítulo. No obstante, si quisiéramos ser escrupulosos deberíamos reservar el segundo término para casos en los que incluyéramos otros ámbitos además de la psicología, como la neurociencia, la lingüística o la informática. En ocasiones se ha hablado, en este segundo sentido más inclusivo, de «ciencia cognitiva» (en singular) o «ciencias cognitivas» (en plural). Otra expresión que a veces se considera equivalente a la de psicología cognitiva es la de «psicología del procesamiento de la información (o del P.I.)». Esta expresión es más restringida. Valdría para las versiones del cognitivismo que conciben la mente como un dispositivo de cómputo de representaciones o manipulación de símbolos. El funcionamiento de la mente consistiría en realizar cálculos, mediante algoritmos, sobre copias del mundo externo. Se trata, probablemente, de la concepción más característica del cognitivismo, y es en la que nos vamos a centrar aquí.

La psicología cognitiva eclosionó en la década de los sesenta del siglo pasado a partir de algunos desarrollos teóricos y técnicos fraguados desde finales de los años cuarenta. A menudo se afirma que el cognitivismo constituyó una especie de revolución contra el reinado del conductismo, el cual fue derrocado y reemplazado por una forma de hacer psicología igual de científica pero más acorde con la naturaleza humana. No obstante, ni el cognitivismo ha tenido tanta unidad interna ni su ruptura con lo anterior fue tan abrupta como para justificar la idea de una revolución.

LA PSICOLOGÍA DEL PROCESAMIENTO DE LA INFORMACIÓN

La concepción del cognitivismo como una revolución científica fue utilizada por algunos psicólogos cognitivos apoyándose en los trabajos de filosofía e historia de la ciencia de Thomas Kuhn (1922-1996), quien publicó en 1962 un libro muy influyente titulado La estructura de las revoluciones científicas (Caparrós, 1985). En este libro, basado sobre todo en la historia de la física, Kuhn defendía que el desarrollo histórico de las ciencias no es acumulativo, sino que consiste en una sucesión de «paradigmas» que constituyen casi cosmovisiones y dictan lo que se debe investigar y cómo. Existen periodos de «ciencia normal» durante los cuales todo marcha bien, es decir, no hay discusiones importantes entre los científicos y se tiene la sensación de que se acumula conocimiento mediante la aplicación del método científico. Sin embargo, en un momento dado comienzan a aparecer anomalías, esto es, datos que no encajan en el paradigma, el cual, entonces, empieza a convertirse en objeto de discusión, o lo que es lo mismo, entra en crisis A medida que aumentan las anomalías el paradigma es cada vez más cuestionado, hasta que finalmente tiene lugar una «revolución» que resuelve la crisis e instaura un nuevo paradigma, el cual inaugura otro periodo de ciencia normal.

El esquema historiográfico kuhniano les parecía idóneo a algunos psicólogos cognitivos para presentarse como adalides de un nuevo paradigma (por ejemplo, Lachman, Lachman y Butterfield, 1979). Supuestamente la historia de la psicología consistiría en una concatenación de paradigmas, y el conductismo sería el que habría definido el periodo de ciencia normal entre aproximadamente 1930 y 1960 (el paradigma previo sería el del funcionalismo, que a su vez habría reemplazado al estructuralismo). Algunas anomalías con las que se encontró el conductismo, como las planteadas por Chomsky (de quien luego hablaremos) y las relativas a los límites biológicos del aprendizaje, le habrían hecho entrar en crisis y ésta se habría resuelto con una revolución que daría lugar a un nuevo paradigma: la psicología cognitiva. Además, desde esta perspectiva se ha solido añadir una valoración positiva del cognitivismo según la cual éste retomó lo que siempre había sido el verdadero objeto de estudio de la psicología, la mente, sólo que ahora lo hacía mediante una metodología científica posibilitada por la tecnología de los ordenadores.

En efecto, las tecnologías de la información desarrolladas tras la Segunda Guerra Mundial dieron forma al ariete metodológico con que se abrió camino el cognitivismo. De hecho, el concepto clave de la psicología cognitiva es seguramente el de «procesamiento de información». En torno a él gira la teorización de la actividad. Lo psicológico consiste en —o se reduce a— procesamiento de información. Ulric Neisser (19282012), que pasa por ser el primero en utilizar la expresión «psicología cognitiva», lo expresaba del siguiente modo en su manual así titulado, publicado en 1967:

«[U]n libro como este puede llamarse “La información del estímulo y sus vicisitudes”. Tal como se emplea aquí, el término “cognición” se refiere a todos los procesos mediante los cuales el ingreso [input] sensorial es transformado, reducido, elaborado, almacenado, recobrado o utilizado. […] [T]érminos como sensación, percepción, imaginación, recuerdo, solución de problemas y pensamiento, entre otros, se refieren a etapas o aspectos hipotéticos de la cognición» (Neisser, 1967/1979, p. 14).

Desde un punto de vista más amplio, suele decirse que en el surgimiento de la psicología del procesamiento de la información, reconocible a finales de los sesenta en obras como la de Neisser, confluyeron diferentes desarrollos teóricos y científico-técnicos, algunos muy ligados a la investigación militar motivada por la Segunda Guerra Mundial y la Guerra Fría. Entre ellos podemos destacar cinco: la teoría de la información y la cibernética, la inteligencia artificial, la psicología experimental británica, la psicología aplicada norteamericana y el conductismo mediacional, y la lingüística de Noam Chomsky.

La teoría de la información y la cibernética

Elaborada por el matemático e ingeniero Claude E. Shannon (1916-2001) y el biólogo Warren Weaver (1894-1978) a finales de los cuarenta, la teoría de la información pretendía servir de herramienta para analizar el flujo de información por un canal cualquiera, midiéndola en bits (la unidad de medida que aún se utiliza en informática). Definían un bit como la unidad de información mínima que se precisa para elegir entre dos alternativas equiprobables. En la Universidad de Harvard, George Armitage Miller (1920-2012) aplicó esa teoría a la psicología en un famoso artículo cuyo título, «El mágico número 7±2», hacía referencia a las unidades de información —entre 5 y 9— que es capaz de procesar la mente humana (Miller, 1956/1983). Se basaba en experimentos con tareas de diferenciación de estímulos, discriminación de fonemas, recuerdo de ítems o cálculo de cifras. No obstante, Miller advirtió de que el bit no constituía una unidad de medida psicológicamente relevante, porque los sujetos pueden agrupar los elementos de la estimulación sensorial que reciben y, en función de la agrupación que realicen, tratar como unidades de información cantidades de estímulos distintas. Por eso Miller propuso una nueva unidad de medida, que denominó chunk. Su artículo, pues, se refería a 7±2 chunks. Posteriormente este tipo de mediciones se trasladaron a las investigaciones sobre la memoria operativa o de trabajo (working memory) y la memoria a corto plazo. El artículo de Miller quedó como un clásico de la psicología cognitiva.

La cibernética es la tecnología de control electrónico de las máquinas, antecedente de la actual informática y otra de las fuentes del concepto moderno de información. El principal fundador de la cibernética fue el matemático norteamericano Norbert Wiener (1894-1964), quien en 1948 defendió que los modelos matemáticos de control de la comunicación en máquinas también pueden aplicarse a los seres vivos, incluyendo los humanos (Wiener, 1961/1985). Uno de los conceptos más importantes a este respecto era el de feedback (realimentación o retroalimentación), procedente de los servomecanismos (aparatos electromecánicos). La retroalimentación implica que hay un intercambio de información entre el servomecanismo y el entorno, en virtud del cual el primero es regulado por el segundo. Así funciona, por ejemplo, el termostato de la calefacción, que se enciende o se apaga de acuerdo con su medición de la temperatura ambiente. El sistema nervioso central podría considerarse, entonces, un dispositivo basado en la retroalimentación, porque su funcionamiento está regulado por un intercambio de información con el entorno. Se activa o desactiva en función de las consecuencias de esa activación. Esta idea de información como intercambio de datos con el entorno, propuesta por Wiener, influyó en George A. Miller.

La inteligencia artificial

La inteligencia artificial (a veces nombrada por sus siglas, I.A.) fue también un antecedente de la informática. Su paternidad suele atribuirse al matemático inglés Alan M. Turing (1912-1954), muy conocido por el juego o prueba de la imitación que propuso en 1950, a veces denominado «test de Turing» (Turing, 1950/1984). Ideó asimismo la «máquina de Turing», que impulsó la construcción de ordenadores y consistía en un modelo formal que describía el funcionamiento de un dispositivo de cómputo basado en la inserción de símbolos en una cinta.

La prueba de Turing

La prueba de Turing fue la base de la inteligencia artificial y pretendía resolver por vía práctica la cuestión de si las máquinas pueden pensar. Imaginemos una situación en que una persona recibe respuestas mecanografiadas a las preguntas que envía a la habitación de al lado, con la cual no tiene otro medio de comunicación. En esa habitación hay un hombre y una mujer, y el objetivo de quien recibe las respuestas es adivinar cuál es el hombre y cuál la mujer, pero teniendo en cuenta que el objetivo del hombre es engañarle y, por tanto, mentirá. Supongamos ahora que una máquina sustituye al hombre. ¿Sería capaz de darse cuenta de la sustitución la persona que hace las preguntas? Dicho en términos más generales: sin contacto sensorial directo, ¿podría un ser humano averiguar si su interlocutor es una persona o una máquina? En caso negativo, es perfectamente legítimo afirmar que las máquinas piensan. Esto es lo que defendía Turing.

Pese a la sencillez de su formulación, la prueba de Turing fue muy controvertida, aunque su idea de que las máquinas piensan se extendió rápidamente. En 1956 el Dartmouth College de Hanover, New Hampshire, auspició una reunión científica que ha pasado a la historia como la Conferencia de Dartmouth y que algunos consideran la puesta de largo del cognitivismo. A esta reunión acudieron investigadores en inteligencia artificial —Marvin Minsky (1927-), Herbert A. Simon (19162001), Allen Newell (1927-1992)— y en ella se habló por vez primera de la analogía o metáfora del ordenador, según la cual el ordenador podría ser un buen modelo de la mente humana y, por tanto, la inteligencia artificial podría tener implicaciones psicológicas importantes.

La analogía del ordenador

En efecto, la analogía del ordenador se diseminó por la psicología cognitiva y la neurociencia hasta prácticamente nuestros días. Al igual que la prueba de Turing, es bastante sencilla de exponer y ha sido muy controvertida. Se basa en la superposición de dos distinciones: la clásica distinción filosófica entre el cuerpo y la mente, y la distinción técnica entre el ordenador y los programas implementados en él. La mente equivaldría a los programas, es decir, al software. El cuerpo, y más en concreto el cerebro o el sistema nervioso, equivaldría al hardware, es decir, al soporte físico de los programas (el disco duro, el cableado interno del ordenador, los microchips, las placas de memoria, etc.).

En realidad, analogías similares se venían planteando desde al menos diez años antes, cuando se habían empezado a concebir ordenadores muy rudimentarios. Organizado por la Fundación Hixon, en 1948 tuvo lugar en el Instituto de Tecnología de California el conocido como Simposio de Hixon, dedicado debatir sobre «los mecanismos cerebrales del comportamiento». Participó en él el matemático John von Neumann (1903-1957), uno de los padres de los ordenadores, quien comparó el ordenador con un cerebro (no en vano los ordenadores comenzaron llamándose «cerebros electrónicos»). Lo que ocurrió en la segunda mitad de los cincuenta es que la mecha prendió definitivamente y la analogía del ordenador se encauzó de tal manera que acabó penetrando en la psicología, convertida ya, a mediados de los sesenta, en psicología del procesamiento de la información.

Ahora bien, desde muy pronto coexistieron dos sensibilidades distintas a la hora de entender la analogía del ordenador. Algunos la interpretaban en sentido fuerte o literal y otros en sentido débil o puramente metafórico. Refiriéndose a lo mismo, a veces también se ha hablado de inteligencia artificial «fuerte» y «débil». No obstante, la interpretación débil de la analogía ha sido, en términos generales, más propia de la psicología cognitiva, mientras que la versión fuerte ha sido más propia de la inteligencia artificial. Veamos en qué consiste cada una.

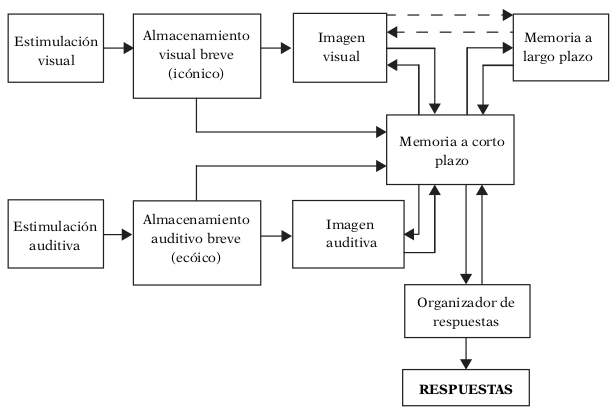

Entendida en su sentido débil, la analogía del ordenador supone que la mente humana no es realmente un programa informático, sino que los programas informáticos simulan el funcionamiento de la mente y, por tanto, pueden tener un gran valor heurístico a la hora de entender las leyes que regulan dicho funcionamiento. De ahí que los psicólogos cognitivos hayan representado gráficamente la actividad psicológica humana mediante secuencias de instrucciones algorítmicas o diagramas de flujo de información semejantes a los empleados para representar los programas informáticos (véase un ejemplo en la figura 1). Trasladada a la inteligencia artificial, la versión débil de la analogía del ordenador implica que la simulación del pensamiento humano realizada por algunas máquinas es sólo eso, simulación, no auténtico pensamiento.

Entendida en su sentido fuerte, la analogía del ordenador supone que no hay una diferencia sustancial entre la mente y un programa informático. Si es posible representar el funcionamiento de la mente mediante los mismos recursos que se utilizan para escribir un programa de ordenador, entonces es que la mente no difiere en nada de un programa de ordenador. La mente no es más que un sistema de cómputo. Trasladado a la inteligencia artificial, eso significa que las máquinas realmente piensan. A finales de los 50 Simon y Newell, representantes de la versión fuerte de la inteligencia artificial, se ampararon en ella para diseñar un «solucionador general de problemas» con el que pretendían formalizar un algoritmo que pudiera resolver tareas complejas de todo tipo, desde ganar una partida de ajedrez hasta demostrar un teorema matemático, pasando por descifrar acertijos o solucionar enigmas aritméticos (Newell. Shaw y Simon, 1959). Simon y Newell se basaron en la aplicación de los algoritmos que según ellos utilizamos los seres humanos para resolver esos problemas. Defendían que cualquier clase de inteligencia, humana o no, consiste en un procesamiento de símbolos. Nótese, eso sí, que la versión fuerte de la metáfora del ordenador no implica que los circuitos neuronales sean equivalentes a los circuitos del ordenador (esta identificación la exploraría posteriormente el conexionismo, como veremos después).

Aunque a menudo se usan indistintamente los términos «analogía» y «metáfora», podemos reservar el primero para la versión fuerte de la misma y el segundo para su versión débil, ya que esta última es la que toma la analogía del ordenador en un sentido estrictamente metafórico. La versión fuerte, en cambio, lleva la analogía hasta sus últimas consecuencias y sostiene que las máquinas piensan y no hay realmente una distinción entre el cerebro y el ordenador, sino que la mente es lo mismo que un programa informático, si bien implementado en un soporte orgánico y no en circuitos integrados de silicio.

La habitación china

Uno de los más conocidos críticos de la analogía del ordenador, especialmente de su versión fuerte, ha sido John Searle (1932-), de la Universidad de California en Berkeley. En 1980 formuló su argumento de la «habitación china», como se le suele llamar, con el que intentaba demostrar que, si aplicáramos la prueba de Turing a la vida real, estaríamos obligados a sostener que se puede hablar un idioma sin entender el significado de sus palabras. El argumento de Searle tiene una estructura similar a la prueba de Turing, pero pretende reducir al absurdo la actitud de quienes toman la metáfora del ordenador en un sentido fuerte.

El argumento es el siguiente (Searle, 1980). Consideremos un ordenador en el que se ha instalado un programa de traducción de chino. Hoy estos traductores automáticos son populares, pero siguen consistiendo esencialmente en lo mismo que cuando Searle expuso su argumento hace más de tres décadas: conjuntos de instrucciones que indican cómo sustituir símbolos de unos idiomas por símbolos de otros idiomas. ¿Diríamos que el ordenador entiende el chino? Imaginemos ahora que una persona que no habla chino se mete en una habitación donde encuentra papelitos con símbolos chinos, es decir, ideogramas cuyo significado desconoce. Ahora esa persona recibe una hoja con instrucciones —en su lengua materna— donde se le pide que combine los símbolos chinos de una determinada manera y saque la combinación fuera de la habitación. Pues bien, tras hacer esto varias veces con nuevos símbolos y nuevas instrucciones, la persona se entera de que los ideogramas que le daban eran preguntas de hablantes chinos que estaban fuera de la habitación, mientras que las instrucciones servían para combinar los símbolos de tal modo que la combinación resultante consistía en respuestas a esas preguntas. Dado que había seguido bien las instrucciones, las personas chinas de fuera de la habitación habían pensado que un auténtico hablante de su idioma estaba respondiendo las preguntas. Obviamente, tras descubrirse el truco, nadie diría que la persona encerrada en la habitación entiende el chino. ¿Por qué decir, entonces, que una máquina de traducción sí lo entiende?

Lo que quería hacer Searle con su ejemplo de la habitación china era subrayar que la mente no sólo consiste en sintaxis —concatenaciones de símbolos procesándose según ciertas reglas— sino que también incluye contenido semántico, o sea, significados: los símbolos son símbolos de algo, y conocer ese algo es esencial para comprender el funcionamiento de la mente. Por lo demás, los propios psicólogos cognitivos acabaron advirtiendo ciertas limitaciones metodológicas de la analogía del ordenador (Vega, 1982).

Sin embargo, quizá el principal problema de la analogía es que ni siquiera vale como metáfora —o sea, en su versión débil— por la sencilla razón de que no es una metáfora, sino una metonimia: toma la parte por el todo. Los ordenadores no son más que instrumentos de los que se sirve nuestra actividad como seres humanos, y en ese sentido son partes de dicha actividad. No sirven como modelos de nuestra actividad porque son parte de ella. Son herramientas nuestras, con las que intentamos lograr ciertos propósitos. Por sí mismos, ellos no actúan. Su funcionamiento es puramente mecánico. No se les pueden atribuir funciones psicológicas. Somos nosotros, en tanto que observadores, quienes leemos el resultado del funcionamiento del ordenador en términos de información. Sólo cabe hablar de información cuando es informativa para alguien. En el fondo, ni siquiera tiene sentido afirmar que los programas informáticos consisten en instrucciones de manipulación de símbolos. Los símbolos sólo son símbolos para quien sepa interpretarlos como tales. Y las instrucciones sólo son instrucciones desde el punto de vista del programador humano, que es quien las escribe persiguiendo determinados fines; por ejemplo, traducir automáticamente un texto, guiar un misil, ganar una partida de ajedrez o entretenernos con un videojuego.

La computación sobre representaciones

Antes dijimos que la versión fuerte de la analogía del ordenador ha sido más propia de la inteligencia artificial, mientras que la psicología cognitiva ha tendido a recurrir a la versión débil. Aunque esto es así, también conviene tener en cuenta que la psicología del procesamiento de la información se basa en una concepción de lo que es una función psicológica que coincide con la definición de pensamiento con la que Turing sentó las bases de la inteligencia artificial. Igual que para Turing pensar era realizar cómputos sobre símbolos (ya hemos dicho que la «máquina de Turing» consistía en una cinta marcada con una secuencia de símbolos), para los psicólogos del procesamiento de la información las funciones psicológicas se definen básicamente en términos de computaciones de símbolos, entendidos éstos como representaciones mentales procedentes de la información recibida a través de los órganos sensoriales. Esta fusión conceptual entre tecnología de la información y psicología fue posible porque en el cognitivismo confluyeron tradiciones de psicología experimental y del aprendizaje que ya estaban elaborando modelos del funcionamiento de la mente o de procesos comportamentales complejos. Veámoslas.

La psicología experimental británica

Durante los años cuarenta y cincuenta, en torno al laboratorio de psicología de la Universidad de Cambridge, se formó un grupo de investigadores del que salieron trabajos que la psicología cognitiva adoptaría como propios. El laboratorio estaba bajo la dirección de Frederick Charles Bartlett (1886-1969) desde 1922 y en él se desarrollaban investigaciones que podemos calificar de funcionalistas tomando este término en un sentido muy amplio, es decir, sin restringirlo a los autores norteamericanos de principios de siglo. Aunque hizo experimentos sobre percepción y memoria, Bartlett no era un psicólogo cognitivo y ni siquiera puede decirse que sus planteamientos teóricos fuesen compatibles con el cognitivismo, ni menos aún con la psicología del procesamiento de la información. Su perspectiva tenía puntos en común con algunas tendencias constructivistas que trataremos más adelante, pues otorgaba una gran importancia a los factores socioculturales y a la ontogénesis del sujeto. Su papel fue más bien el de promover y aglutinar una serie de investigaciones algunas de las cuales, como las de Kenneth J.W. Craik (1914-1945) y sobre todo las de Donald E. Broadbent (1926-1993), sí pasarían a formar parte de la nómina de aportaciones clásicas del cognitivismo.

Craik conocía la ingeniería de su época y adoptó una concepción cibernética del ser humano similar a la de los autores norteamericanos que mencionamos más arriba (Craik, 1948). Apoyado por Bartlett, formuló la teoría de los «niveles de ejecución», que supone que el comportamiento humano se organiza en virtud de distintos niveles jerárquicos y éstos se controlan unos a otros. Esta idea fue precursora de otra a la que han recurrido con frecuencia los psicólogos cognitivos, según la cual existen varios niveles de procesamiento de la información e incluso varios niveles de análisis de la actividad psicológica, cada uno con peculiaridades y abordable con metodologías específicas (Craik y Lockhart, 1972/1980; Miller, Galanter y Pribram, 1960/1983).

Por su parte, Broadbent (1958/1983) sintetizó los principales resultados de la psicología experimental americana (véase el siguiente epígrafe) y británica, centrándose sobre todo en los de carácter más aplicado e interesándose particularmente por los relativos a la atención, que constituyó el campo de estudio donde él mismo hizo sus aportaciones más relevantes. A la hora de realizar esa síntesis adoptó un punto de vista cibernético similar al de K.J.W. Craik en tanto que comparó el sistema nervioso con un canal de comunicación o un circuito por el que circulan datos. También fue uno de los primeros autores en elaborar diagramas de flujo de información para explicar la actividad psicológica, que luego serían omnipresentes en la psicología cognitiva.

La psicología aplicada norteamericana y el conductismo mediacional

Al igual que en Gran Bretaña, durante los años cuarenta y cincuenta se financiaron en los Estados Unidos numerosas investigaciones de psicología experimental y aplicada relacionadas con el ejército y la industria, que a la sazón estaba gozando de un gran desarrollo. El ajuste hombre-máquina y la ergonomía eran temas prioritarios. Así, en el Laboratorio de Psicoacústica de la Universidad de Harvard se llevaron a cabo investigaciones sobre el efecto del ruido en la ejecución de diferentes tareas; en el Laboratorio de Psicología de la Aviación de Ohio se exploraron las características de los patrones de estímulos sensoriales que facilitaban el trabajo de los operadores humanos en ciertos puestos de control; y varias unidades de psicología aplicada auspiciadas por las fuerzas armadas -que también firmaron contratos con algunas universidades- dedicaron sus recursos a investigaciones sobre la percepción espacial, la locomoción o la recepción e interpretación de la información por medios electrónicos (algo muy importante, por ejemplo, para los controladores de radares).

Sin embargo, en aquel tiempo el conductismo dominaba la escena académica norteamericana y, para algunos jóvenes psicólogos, representaba el enemigo a batir. Ahora bien, el conductismo era cualquier cosa menos homogéneo. Recordemos que desde al menos la década de los treinta hubo versiones que un poco más tarde Skinner englobaría bajo la etiqueta, un tanto despectiva, de «conductismo metodológico». Dos ejemplos de ello eran el conductismo propositivo o molar de Tolman y el neoconductismo o conductismo mecanicista de Hull. Tolman había introducido variables intervinientes, propósitos y cogniciones, y Hull había introducido cadenas de estímulos y respuestas a partir de las cuales se produciría la respuesta final del organismo. Existían asimismo versiones del conductismo denominadas informales o mediacionales —o neohullianas, las que se basaban en Hull—, que liberalizaban aún más la exigencia de que las variables introducidas entre E y R se definieran operacionalmente o como variables observables. Conductistas informales o mediacionales fueron Karl S. Lashley (1890-1958), Neal E. Miller (1909-2002) —a no confundir con George A. Miller— y Charles E. Osgood (1916-1991). Lashley asistió al Simposio de Hixon de 1948, antes mencionado, donde presentó una comunicación titulada «El problema del orden serial en la conducta», en la cual intentaba aproximar la psicología a la neurología y defendía el estudio de los comportamientos complejos en términos de secuencias organizadas jerárquicamente. Neal E. Miller, alumno de Hull, enfatizó la necesidad de flexibilizar los conceptos neoconductistas para aplicarlos a situaciones de la vida real, desarrolló la llamada «teoría del aprendizaje social» —una especie de psicología social conductista— e intentó traducir los principios del psicoanálisis a la psicología del aprendizaje. Por último, Osgood se basó en Hull para desarrollar una concepción de los procesos cognitivos como cadenas de estímulos y respuestas inobservables. Una de sus contribuciones más conocidas fue la prueba del «diferencial semántico», que aplicaba su esquema neohulliano al lenguaje y, en concreto, a la evaluación de la creación de significados por parte de los sujetos.

Así pues, algunos planteamientos del conductismo mediacional eran casi indistinguibles de los de la psicología cognitiva, y algunos de los autores que han pasado a la historia como clásicos o pioneros de la psicología cognitiva eran conductistas mediacionales. Incluso en un libro que ha quedado como un clásico de la psicología cognitiva, Planes y estructuras de la conducta, publicado en 1960 por George A. Miller —de quien ya hemos hablado— junto con Eugene Galanter (1924-2016) y Karl H. Pribram (19192015), los autores se llamaban a sí mismos «conductistas subjetivos». Eso sí, lo hacían ya con cierta sorna, conscientes de que las horas del conductismo mediacional estaban contadas, porque se solían incluir tantas mediaciones inobservables entre estímulos y respuestas que ya no tenía sentido seguir calificando a aquello de conductismo. Miller, Galanter y Pribram proponían un esquema teórico basado en la organización jerárquica y planificada del comportamiento, que giraba en torno a lo que ellos consideraban la unidad elemental de la conducta, una especie de bucle de retroalimentación al que se denominaba test-operate-test-exit o, por sus siglas, TOTE. Se podría traducir como probar-actuar-probar-detenerse y constituiría el principio de funcionamiento básico de cualquier conducta (humana o mecánica): ante un problema ponemos a prueba una acción, evaluamos los resultados y, cuando el problema está resuelto, dejamos de actuar.

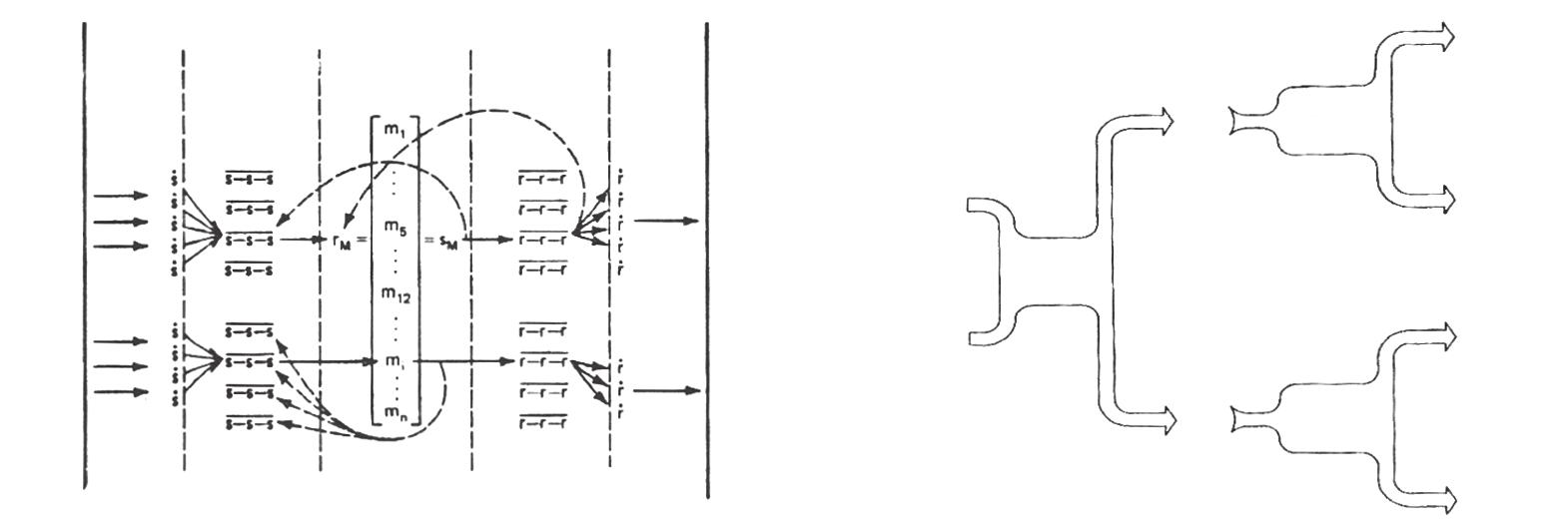

Para terminar este apartado y mostrar hasta qué punto se parecían los planteamientos del conductismo mediacional y el cognitivismo, comparemos las dos representaciones gráficas de la figura 2. Ambas intentaban modelizar dimensiones de la actividad psicológica humana. El gráfico de la izquierda pertenece a un libro de Osgood (1980/1986, p. 94), el conductista mediacional neohulliano. El de la derecha está sacado de la Introducción a la psicología cognitiva de Peter H. Lindsay y Donald A. Norman (1977/1986, p. 806).

Como el propio Skinner advirtió, la única versión del conductismo que se oponía frontalmente al cognitivismo era la radical, es decir, la suya, porque no admitía ningún tipo de mediación entre E y R (de hecho, ni siquiera se consideraba a sí misma una psicología E-R, porque se basaba en el condicionamiento operante y no en el clásico). Sea como fuere, para los primeros psicólogos cognitivos el conductismo fue, más que un enemigo a batir, un padre al que matar, por emplear la conocida expresión freudiana referida al mito de Edipo. Los psicólogos cognitivos eran, en buena medida, hijos del conductismo, aunque quisieran emanciparse enfrentándose a él.

La lingüística de Noam Chomsky

Una quinta fuente del cognitivismo fue la lingüística del estadounidense Avram Noam Chomsky (1928-). Influyó, por ejemplo, en autores como George A. Miller. La crítica de Chomsky al conductismo dio aliento a los jóvenes psicólogos que deseaban distanciarse de los planteamientos de Skinner e incluso de los conductistas mediacionales, pese a su cercanía a algunos presupuestos de estos últimos. En términos más generales, la lingüística generativa propuesta por Chomsky proporcionaba a la psicología un marco conceptual mentalista (para él las reglas gramaticales residen en la mente) e innatista (supone que hay una gramática universal innata) que encajaba a la perfección con el cognitivismo.

En efecto, Chomsky (1959/1990) escribió una enérgica crítica al libro que Skinner había publicado en 1957, La conducta verbal, en el cual exponía su aproximación conductista radical al lenguaje humano. Chomsky esgrimía un argumento que iba directo contra la línea de flotación del conductismo radical. Sostenía que la definición funcional skinneriana de los estímulos y las respuestas —según la cual ambos se definen recíprocamente, de modo que un estímulo es aquello que suscita una respuesta y una respuesta es cualquier cosa que el organismo haga relacionada funcionalmente con ciertos estímulos— es científicamente vacía, pues de acuerdo con ella es posible llamar estímulo o respuesta a casi cualquier cosa:

«[D]ebemos decidir si llamaremos estímulo a cualquier hecho físico ante el que el organismo es capaz de reaccionar en una ocasión dada o solamente a aquellos ante los que el organismo reacciona de hecho; y, paralelamente, debemos decidir si vamos a llamar respuesta a cualquier parte del comportamiento o sólo a aquellas que están conectadas con los estímulos de acuerdo con unas determinadas leyes» (Chomsky, 1959/1990, pp. 29-30).

«[U]sando la palabra “estímulo” de esta forma ha perdido toda su objetividad. Los estímulos ya no son entonces una parte del mundo físico exterior; han sido devueltos al interior del organismo. Identificamos el estímulo cuando oímos la respuesta» (Chomsky, 1959/1990, p. 33).

«[L]a noción de reforzamiento ha perdido por completo su significado objetivo, si es que alguna vez lo tuvo. […] [U]na persona puede ser reforzada aunque no emita respuesta alguna y […] el “estímulo” reforzante no necesita incidir sobre la “persona reforzada”, o incluso ni necesita existir (es suficiente que se lo imagine o espere)» (Chomsky, 1959/1990, pp. 44-45). «El estímulo que controla la respuesta está determinado por la respuesta misma; no existe un método de identificación independiente y objetivo» (Chomsky, 1959/1990, p. 69).

En definitiva, si definimos los estímulos y las respuestas en términos estrictamente físicos, entonces es difícil identificar leyes que gobiernen la conducta, puesto que ésta no siempre puede relacionarse con estímulos concretos; pero si definimos los estímulos y las respuestas funcionalmente, entonces es arbitrario a qué llamemos estímulos y respuestas, ya que prácticamente cualquier cosa puede ser un estímulo o una respuesta.

Ahora bien, Chomsky (1957/1999) saltó a la fama a finales de los años 50 por sus planteamientos teóricos dentro de la lingüística, que han solido caracterizarse mediante la etiqueta de gramática generativa. Defendía que la adquisición del lenguaje por parte de los niños es posible merced a estructuras neurofisiológicas innatas que soportan lo que él denomina la «estructura profunda» del lenguaje, vinculada a la sintaxis y ligada a una gramática universal de la cual las lenguas concretas (español, inglés, chino, suajili, maratí, quechua, etc.) no serían más que expresiones superficiales. Chomsky (1965/1972) reivindicaba un enfoque cartesiano para la lingüística basado en el racionalismo y el innatismo del filósofo francés del siglo xvii René Descartes. Se trataba de entender el lenguaje como expresión de la racionalidad humana y concebirlo en términos formales, de estructuras abstractas (sintácticas) que constituyen la base sobre la cual se implementan los diferentes idiomas con sus respectivos léxicos y fonemas (así, a partir de ciertas reglas gramaticales pueden producirse una cantidad infinita de oraciones). Además, esas estructuras tendrían un fundamento genético, innato, lo que las convertiría en universales, propias de toda la especie humana. De hecho, Chomsky llegó a proponer la existencia en los niños de un dispositivo de adquisición del lenguaje que les permitiría aprender su lengua materna entre los dos y los doce años de edad. Tal dispositivo, conocido por sus siglas en inglés (LAD, language acquisition device) o español (DAL), equivaldría a un procesador de información lingüística innato programado según las leyes universales de la gramática.

En suma, Chomsky creía que el lenguaje humano se rige conforme a leyes propias, irreductibles a leyes generales de la conducta. Su punto de vista formalista, innatista y crítico con el reduccionismo conductista alimentó las aspiraciones de muchos psicólogos cognitivos a la hora de identificar leyes universales del funcionamiento mental humano, entendidas sobre todo en términos de reglas abstractas.

EL MITO DE LA REVOLUCIÓN COGNITIVA

A la luz de lo que acabamos de ver, se comprenderá que la idea de que la psicología cognitiva supuso una revolución científica es, cuando menos, matizable —y ello al margen del juicio que nos merezca la perspectiva kuhniana en sí misma—. La continuidad entre el conductismo y el cognitivismo fue evidente. Pero, aparte de eso, la unidad de la psicología cognitiva no fue tan grande como para hacer girar en torno a ella la idea de una revolución. Además de los cuatro desarrollos que acabamos de explicar en el apartado anterior, en historias generales de la psicología y ensayos e historias específicas sobre el cognitivismo (Gardner, 1988; Leahey, 2005; Mayer, 1985; Rivière, 1987) ha sido habitual considerar raíces de la psicología cognitiva —e incluso componentes de ésta— tendencias dispares, la mayoría de las cuales tuvieron nada o poco que ver con esos cuatro desarrollos. Entre ellas se encuentran el constructivismo de Piaget y Vygotski (a quienes trataremos más adelante), la teoría de la disonancia cognitiva del psicólogo social Leon Festinger (1919-1989), la teoría New look de la percepción y las investigaciones sobre el pensamiento ligadas al grupo de Jerome S. Bruner (1915-) en los años cuarenta y cincuenta, e incluso la antropología entera tomada como disciplina que, al parecer, estudia las características universales y particulares de la mente humana.

Así pues, muchos psicólogos cognitivos e historiadores han metido en el mismo saco perspectivas teóricas diferentes, cuyo denominador común es simplemente que no eran conductistas. Desde luego, todas hablaban de la mente, pero entendían por mente cosas muy distintas. De hecho, la psicología cognitiva y el conductismo se parecen mucho más entre sí que la psicología cognitiva y los enfoques de Piaget o Vygotski. Meter este tipo de enfoques en el mismo saco que los del cognitivismo sólo valía para justificar la actitud revolucionaria con la que muchos psicólogos cognitivos se autoafirmaban. Parecía que un enemigo común —el conductismo— unía contra él fuerzas aglutinadas en torno a una categoría —la mente— que además se consideraba casi como algo natural: todo el mundo sabe que las personas tenemos mente y la psicología cognitiva viene al fin a estudiarla de un modo científico.

Nosotros, en cambio, suponemos que la única tendencia mínimamente unitaria a la que cabe denominar con cierto rigor psicología cognitiva es la que se aglutinó en torno al procesamiento de la información. Lo que se dio en los años setenta y ochenta, con el cognitivismo ya triunfante, fue un proceso de colonización conceptual habitual en la historia de la psicología, y que volveremos a señalar: la psicología cognitiva tradujo a sus propios términos planteamientos psicológicos que le eran ajenos pero que le servían para autolegitimarse por su prestigio académico o porque permitían narrar un mito de los orígenes similar al que se narra en las historias nacionales o en cualquier reconstrucción de una identidad cuyo nacimiento más o menos remoto sirve para justificar su existencia. Dicho en palabras vulgares, el cognitivismo arrimó el ascua a su sardina y cognitivizó a autores que, como Piaget o Vygotski, se alejaban bastante de lo que sería un tipo ideal de psicólogo cognitivo.